权威榜单突围!七牛云大模型服务性能名列前茅,模型广场助力高效开发

MaaS 大模型市场选择模型难?近日在杭州举办的全球开源创新汇 GOSIM2025 大会上,由清华大学联合工信部中国软件评测中心发布的《2025 大模型服务性能排行榜》给出权威参考——七牛云 AI Cloud 大模型服务在低延迟、高吞吐、模型丰富度等方面的表现亮眼,更以模型广场一站式能力,让“高性能”落地为开发者可感知的高效开发体验。

一、七牛云 AI Cloud 大模型服务性能优势获权威认证

排行榜由清华大学计算机系高性能所所长翟季冬教授在大会应用与智能体(Apps & Agents)论坛上发布,依托清华系清程 AI Ping 平台开展 7×24 小时持续监测,覆盖 20 余家 MaaS 供应商、聚焦 DeepSeek-V3.1、Qwen3-32B 等 5 个热门模型,以开发者最关心的“低延迟”和“高吞吐”为核心,评选各模型榜单前五名。

在这样严苛的评测中,七牛云 AI Cloud 的表现精准命中开发痛点:

DeepSeek-V3.1 响应延迟排名第 2:更快的首字响应,意味着 AI 编程、智能陪伴、复杂任务等需要“即时交互”的场景,能彻底告别“加载卡顿”。比如处理带有代码和文档等上下文知识的信息时,AI 秒级回应,既提升用户体验,也让开发者无需为“交互流畅度”额外优化;

Qwen3-32B 吞吐速度排名第 3:更高的 tokens 生成速度,让文本对话、智能客服等场景效率倍增。依托七牛云的高吞吐服务,可大幅缩短用户等待时间,加速用户问题回复。

当前市场相同模型吞吐相差最高 4.9 倍、延迟相差 4.3 倍,七牛云能在众多模型服务供应商中跻身前列,正是其在 AI Cloud 基础设施、大模型推理优化、高性能服务部署等方面长期技术投入的直接体现。

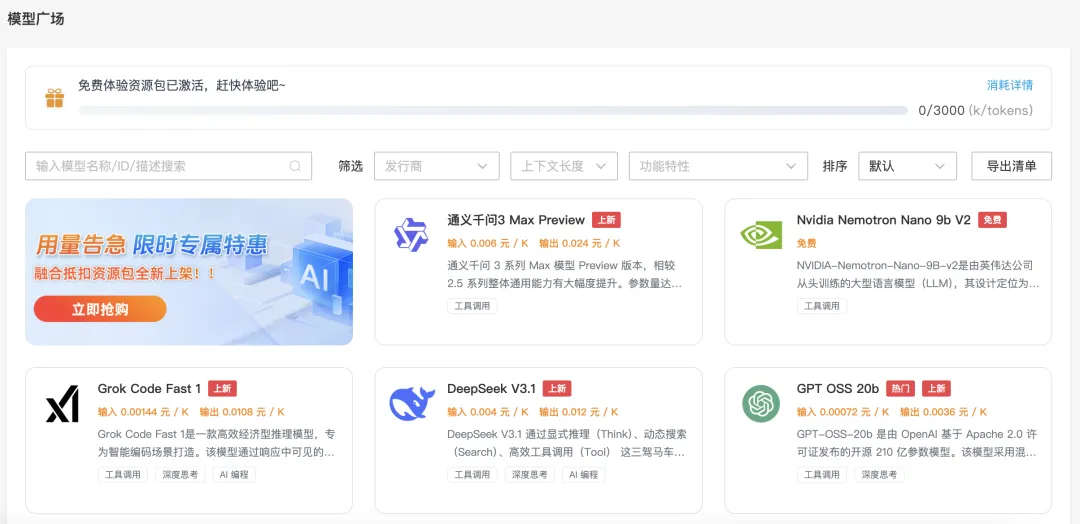

二、性能之外的实力:模型广场一站式解决开发需求

性能之外,七牛云“模型广场”为开发者搭建高效工具箱:

顶尖大模型齐聚:聚合 DeepSeek、Qwen、GLM 等系列顶级开源模型,也有 Claude、Grok 等优秀的闭源模型,无需跨平台切换——简单脚本开发选 Qwen3-Turbo(成本<0.1 美元/100 万 Tokens)快速模型,复杂项目用 DeepSeek-V3.1/GLM-4.5(平衡速度与质量)推理模型,支持函数工具调用、驱动各种 Agent 应用等;

多模型 PK 对比:用户可在 AI 控制台选择多个模型同时进行对话,方便开发者在多个大模型之间的进行响应质量和性能的选择和比较。

多模态能力加持:依托存储、上传优势简化数据链路,集成 OCR/ASR/TTS 等图片和语音 API,无需“拼凑”工具,实现“选模型-做开发-落地应用”闭环。

三、低门槛尝鲜:福利助力快速上手

新用户注册即领 300 万 Tokens 免费额度 (涵盖模型广场中 DeepSeek、Qwen 等全模型通用);企业认证后升级额度,批量采购“模型用量包”再省 30%。登录七牛云小程序或 qiniu.com/ai 模型广场,即可开始高效开发。

从榜单性能到一站式服务,再到低门槛福利,七牛云以开发者需求为核心,持续优化大模型服务。未来更将紧跟技术趋势,助力更多创意快速转化为智能应用。

若你在模型选型、额度领取或开发落地中遇到疑问,欢迎扫码添加小助手,小助手将实时为你解答问题、同步最新服务动态,还可获取专属开发指南,让你的 AI 项目推进更顺畅!