AI玩具的伦理边界与安全治理:如何守护儿童和青少年的数字健康

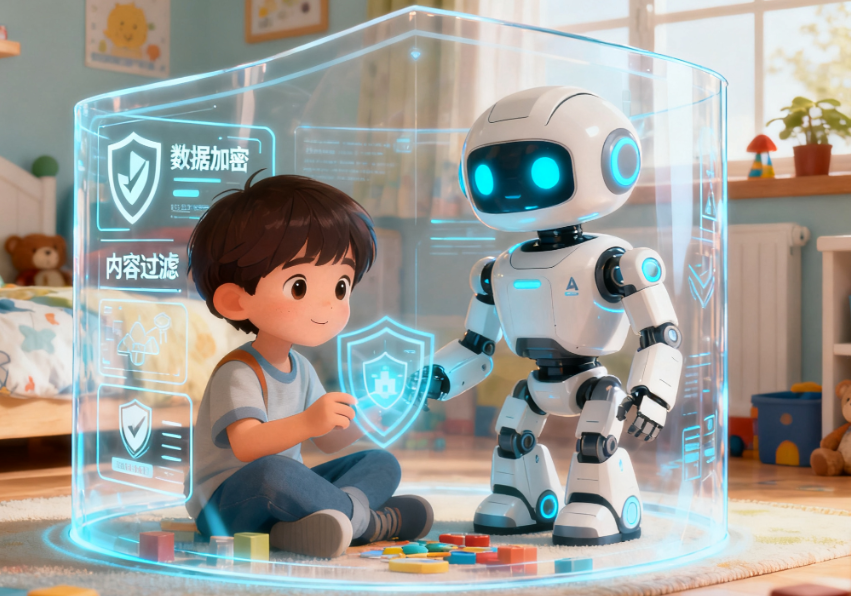

随着AI玩具和智能硬件(如AI智能机器狗、BubblePal、AI故事喜羊羊)的热销,AI陪伴产品对儿童和青少年的影响,以及随之而来的伦理挑战与安全合规问题,已成为行业不可回避的焦点。

幻觉、隐私与过度依赖

1. AI“幻觉”与内容准确性: AI大模型生成的内容具有开放性和创造性,但在儿童教育场景中,“模型幻觉”问题可能导致信息不准确。这对于认知处于发展阶段的儿童可能带来长远影响。

2. 隐私安全: AI玩具涉及用户隐私和敏感数据,例如儿童的语音和行为数据。全球已曝光多起AI玩具数据泄露事件,23%涉及儿童语音及行为数据被滥用。因此,隐私保护的重要性被业界高度认可。

3. 情感依赖与心理风险: 青少年用户可能对AI伴侣上瘾,寻求**“安全、有趣的环境”**。然而,过度依赖AI可能导致对真实生活中复杂情感关系的适应不良。已有案例表明,未成年人因沉迷AI聊天机械人而出现心理危机。联合国决议特别关注情感AI可能对儿童心理健康和社会关系带来的潜在风险。

合规与技术治理的必要性

为保障AI陪伴行业的健康持续发展,政策监管与伦理准则将成为关键。

• 国际监管趋势: 欧盟《AI法案》要求玩具企业通过“隐私-by-design”认证。美国加州参议院通过的法案要求AI聊天机器人必须至少每隔3小时提醒用户“陪聊对象不是人类”,并须设防自杀机制和遵守数据透明规定。

• 国内政策导向: 《人形机器人创新发展指导意见》规划至2025年实现人形机器人批量生产与落地部署,鼓励情感AI研发,旨在通过具备情感交互能力的机器人服务于儿童成长,助力构建“儿童友好”环境。

技术提供方需要构建分层的内容安全策略:

1. 输入输出审核: 在大模型的输入输出层设置额外的内容安全审核能力,或在本地部署安全词库作为兜底措施。

2. 高风险内容识别: 特别注意色情、暴力、恐怖、低俗内容,以及虚假信息、过度引导性言论和用户自伤暗示等高危情绪内容。

3. 青少年的定制化保护: 对于面向未成年人或UGC(用户生成内容)参与度高的产品,需要严禁任何形式的儿童色情、恋童描写。

心理学视角的机制设计

在用户担忧和舆情风险方面,心理学研究提供了新的解决方案。基于心理抗拒理论(reactance theory),简单的禁止或分级限制可能反而激发青少年的窥探欲。专家建议采用以下机制设计:

• 赋予受控自主权: 设计分级、可控的探索区,允许用户在明确的安全框架下有限度地了解争议主题。

• 透明化理由解释: 限制内容时,用清晰、坦诚、目标用户能理解的语言解释限制该内容的原因,而非冰冷的提示。

• 智慧引流与健康替代: AI应成为向导和玩伴,推送高质量、有趣的正面内容,让用户沉浸于积极健康的体验,减少对被禁止内容的关注。

通过技术手段构建安全护栏,结合心理学原理进行产品设计,AI玩具才能真正实现其作为“科技启蒙老师”和“情绪伙伴”的正面价值。