「快速上手」基于DeepSeek-R1大模型推理能力的专属知识库搭建

自七牛云全面集成 DeepSeek-R1 大模型以来,很多开发者朋友非常关心这些问题 —— “如何借力 DeepSeek-R1 提升业务效率?如何快速搭建我们公司的专属 RAG 知识库?”。

为此,我们结合实战经验,从易搭、易用、实惠等角度出发,整理参考步骤如下:

首先,申请七牛云 GPU 云服务器; 第二步,部署 Ollama + DeepSeek-R1 模型 + Open WebUI 服务;最后,基于 Open WebUI 构建专属知识库;

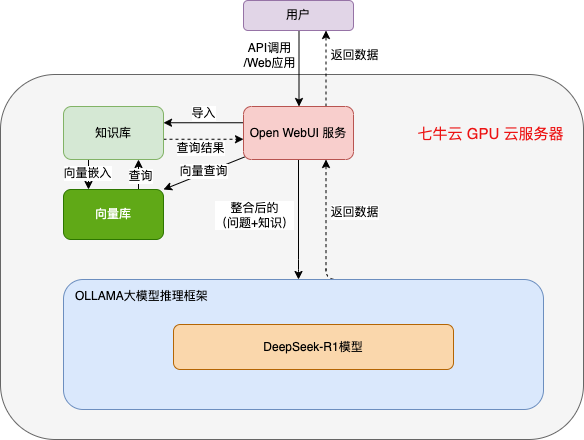

参考以上步骤,即可快速搭建如下图所示的本地专属 RAG 知识库服务 —— 借助 DeepSeek-R1 大模型推理能力,通过问答,充分探索公司本地文档知识宝库(备注:实际部署时,可根据具体资源规划调整部分配置)。

以下,本文将带您快速上手体验 DeepSeek-R1 大模型的部署和基于 Open WebUI 的知识库构建。

一、部署 DeepSeek-R1 + Open WebUI

1.1 Docker 镜像一键部署

# 启动镜像 将会从指定服务器中下载镜像 并运行一个容器,在浏览器地址栏输入<IP>:8000即可访问到open-webui的网页界面# 初次运行容器时 需要等待模型下载完毕后 才能开始正常对话# 7B模型docker run --gpus all -p 8000:8080 -it registry-aigc.qiniu.io/miku-aigc/deepseek7b_ollama_lite_openwebui:0.3.0 # 8B模型docker run --gpus all -p 8000:8080 -it registry-aigc.qiniu.io/miku-aigc/deepseek8b_ollama_lite_openwebui:0.3.0 # 14B模型docker run --gpus all -p 8000:8080 -it registry-aigc.qiniu.io/miku-aigc/deepseek14b_ollama_lite_openwebui:0.3.0 # 32B模型docker run --gpus all -p 8000:8080 -it registry-aigc.qiniu.io/miku-aigc/deepseek32b_ollama_lite_openwebui:0.3.0 # 70B模型docker run --gpus all -p 8000:8080 -it registry-aigc.qiniu.io/miku-aigc/deepseek70b_ollama_lite_openwebui:0.3.01.2 进行对话

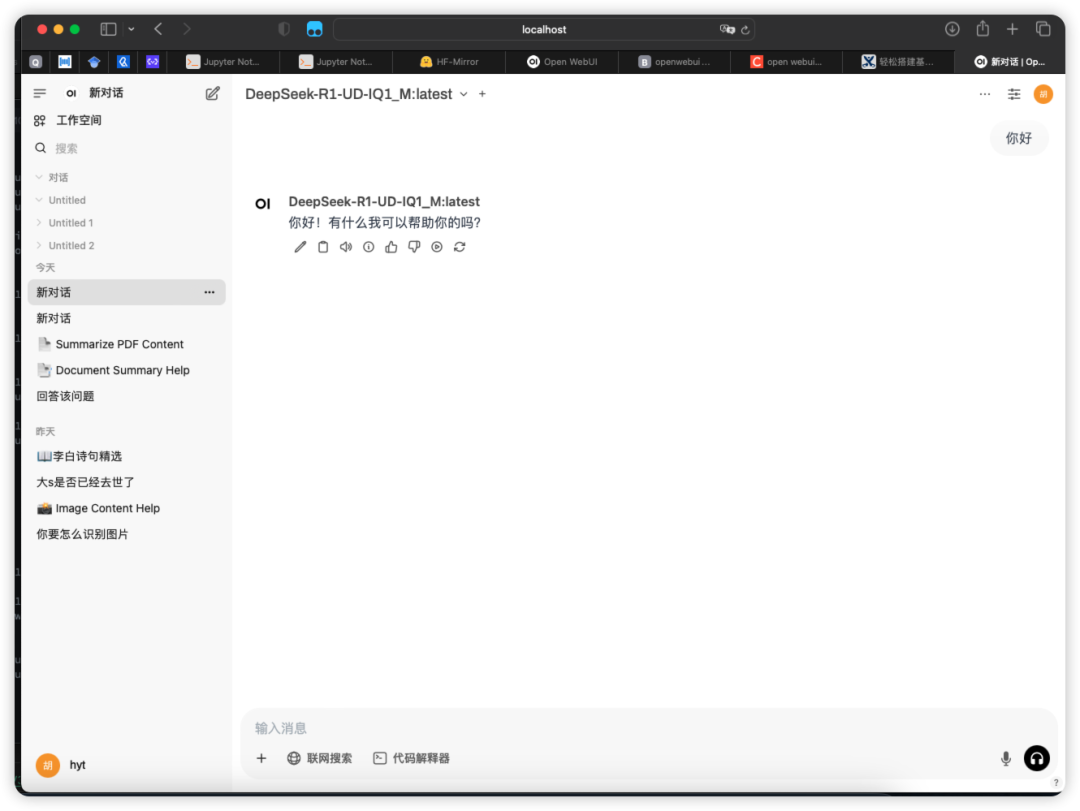

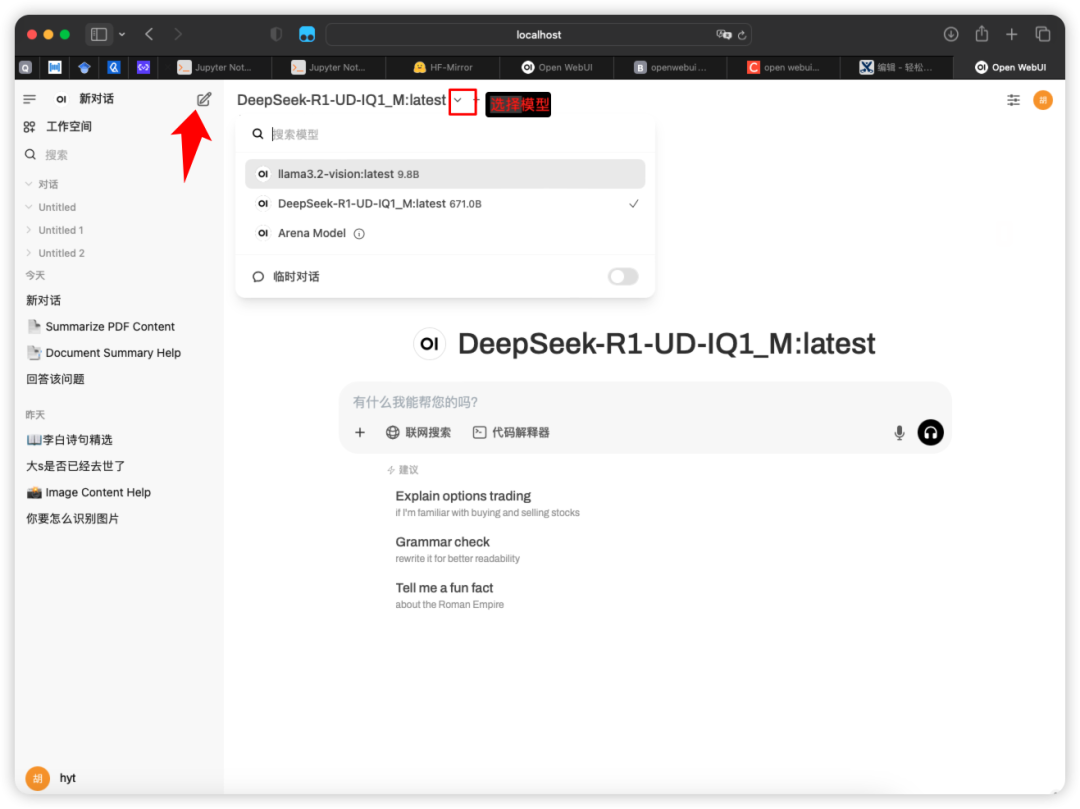

用 Docker 一键部署后,在浏览器地址栏输入 http://localhost:8000 即可访问到 Open WebUI,并进行对话 (注:localhost可以替换为云主机外网 IP 或对应域名)。

二、 知识库的创建和使用

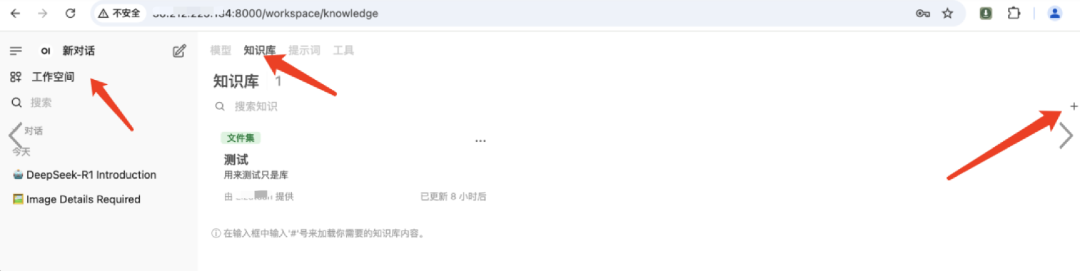

知识库通过 DeepSeek-R1 提供的 Web 页直接操作即可。

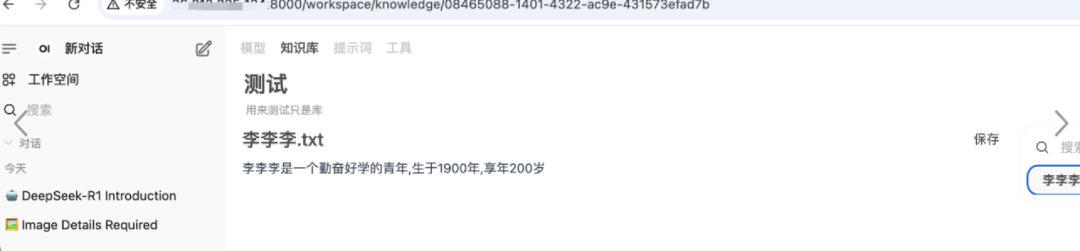

2.1 添加知识库

备注:支持上传各类文本类、办公文档、代码文件等,譬如 .txt、 .md 、 .html 、 .docx 、.pdf 、.java ...

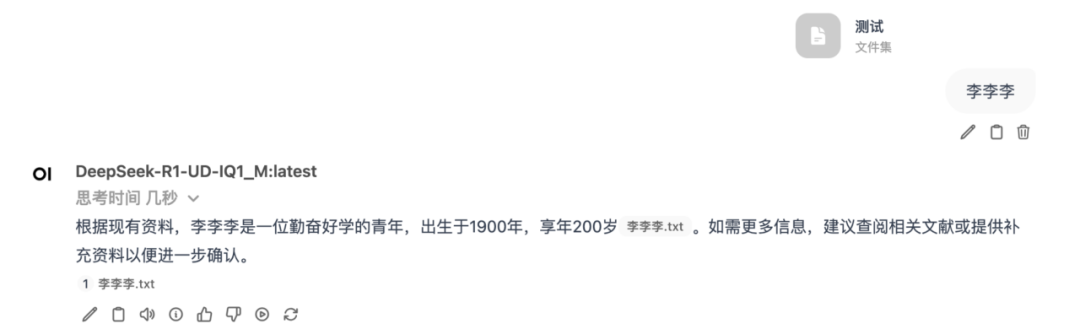

2.2 使用知识库

在对话窗口输入"#"即可引用相应的文档和知识库进行问答:

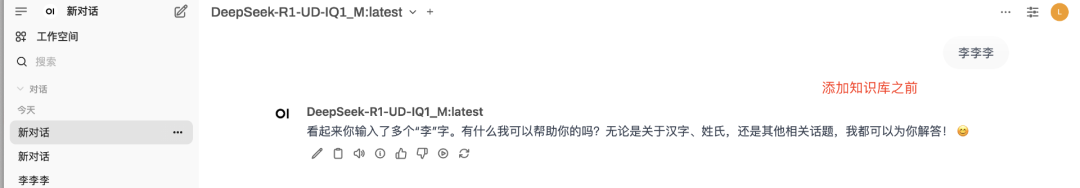

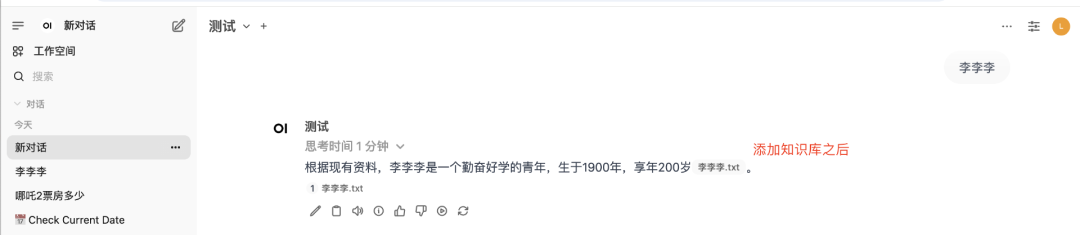

2.3 效果对比

添加知识库前后对比如下:

2.4 补充说明

本地部署的 Open WebUI 提供一组 API,支持用户将大模型+知识库能力集成到自己的其他业务系统中,详情请参考七牛云官网 AI 大语言模型推理服务 API 文档。