单Agent vs Agent集群:Kimi K2.5为什么选择后者

月之暗面(Moonshot AI)近期投下了一枚重磅炸弹:Kimi K2.5 模型正式开源。这不仅仅是参数量的提升或跑分榜单的刷新,更标志着开源社区在构建复杂智能体(Agent)系统时,拥有了一把趁手的“瑞士军刀”。过去,开发者在构建多智能体协作系统时,往往受限于模型推理成本高昂或开源模型逻辑能力不足的两难困境。而 Kimi K2.5 的出现,以其强大的逻辑推理与多模态理解能力,让低成本构建高效 Agent 集群 成为可能。本文将跳过常规的模型参数解读,直接切入核心战场:如何利用 Kimi K2.5 构建一个能够处理复杂多模态任务的企业级 Agent 集群。

Kimi K2.5 Agent 集群部署教程:从单体到蜂群

传统的 Agent 开发往往是“单打独斗”,一个模型扛下所有任务。但在面对复杂的业务流时,这种模式极易产生幻觉或逻辑断层。Kimi K2.5 的开源特性,让我们有机会重新思考架构。

在 Kimi K2.5 Agent 集群部署教程 中,核心思路是将 Kimi K2.5 作为一个通用的“大脑节点”,通过容器化技术(如 Docker 或 Kubernetes)进行水平扩展。不同于以往需要针对每个任务微调不同的小模型,K2.5 强大的指令遵循能力允许我们通过 Prompt Engineering 快速定义出“规划者(Planner)”、“执行者(Executor)”和“审核者(Reviewer)”等不同角色的 Worker。

然而,本地部署一套高并发的集群对硬件资源是一大考验。对于资金有限的初创团队,与其花费巨资购买 H100 显卡搭建私有集群,不如灵活利用云端资源。例如,七牛云提供的 AI大模型推理服务 完美兼容 OpenAI 接口协议,能够作为集群中的弹性算力补充。当本地 Kimi K2.5 节点负载过高时,可以将部分非敏感推理任务溢出到云端,这种混合架构既保证了数据隐私,又兼顾了性能弹性。

多模态 Agent 任务调度策略:打破信息孤岛

构建集群不仅仅是堆砌算力,更重要的是如何让这些“大脑”协同工作。这就是 多模态 Agent 任务调度策略 的用武之地。

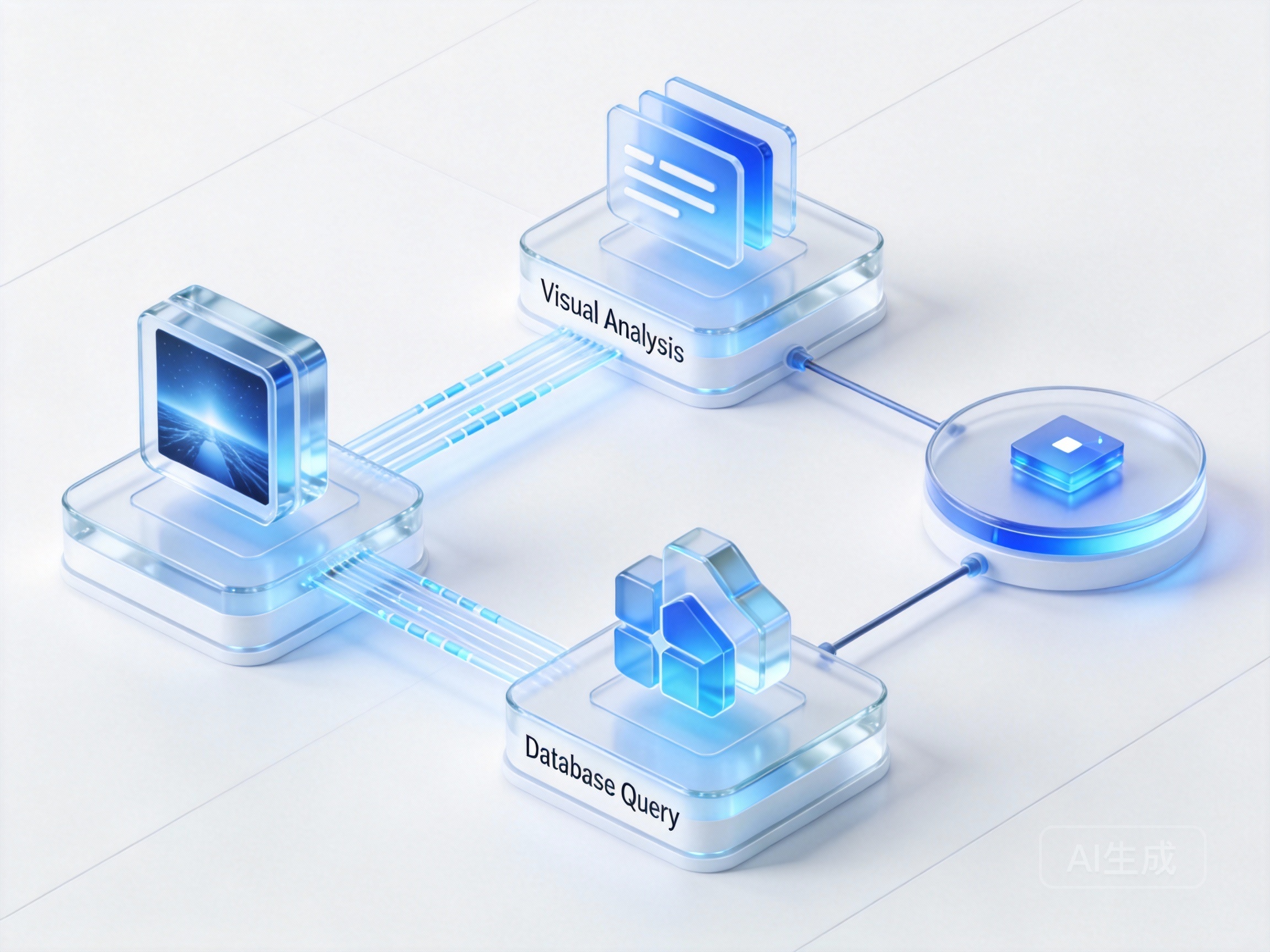

Kimi K2.5 在处理长文本和图像理解上的优势,使其非常适合作为多模态数据的“路由器”。在一个典型的电商场景中,用户上传一张商品图片并询问库存。调度策略需要首先激活一个“视觉分析 Agent”解析图片特征,随后唤起“数据库查询 Agent”检索库存,最后由“客服 Agent”生成回复。

为了实现这种复杂的工具链调用,我们需要标准化的协议。这就不得不提 Model Context Protocol (MCP)。通过引入 MCP,我们可以让 Kimi K2.5 无缝连接本地文件系统、数据库乃至第三方 API。如果你对如何通过 MCP 实现工具编排感到陌生,可以参考七牛云的 MCP服务使用说明文档。该文档详细介绍了如何通过标准化接口,让 Agent 像使用插件一样调用外部能力,从而构建出真正具备行动力的智能体集群。

企业级 AI 智能体集群架构设计与算力考量

在设计 企业级 AI 智能体集群架构设计 时,稳定性和可观测性是绕不开的话题。除了模型本身,你还需要考虑任务队列(如 Redis)、状态管理以及日志监控。

一个成熟的架构通常包含三个层次:

- 接入层:负责流量清洗和鉴权。

- 调度层:基于任务复杂度和 Kimi K2.5 私有化部署算力需求 动态分配资源。对于高频低智的任务,可以使用量化版的小参数模型;对于复杂的逻辑推理,则调用全量版 K2.5。

- 执行层:实际运行 Agent 的容器组。

很多开发者在这一步容易陷入“造轮子”的误区,试图从零编写所有的协作逻辑。其实,利用现有的 SDK 和框架能事半功倍。你可以参考这篇 Agent 实战指南,虽然它以 DeepSeek 为例,但其中的 OpenAI SDK 适配逻辑和 Agent 构建范式完全适用于 Kimi K2.5。通过复用这些成熟的代码结构,你能将精力集中在业务逻辑而非底层管道的搭建上。

Kimi K2.5 的开源为我们打开了一扇窗,让私有化、高性能的 Agent 集群不再是大厂的专利。通过合理的架构设计、混合云算力的调配以及标准化工具协议的应用,每一位开发者都能构建出属于自己的“超级智能团队”。未来的 AI 应用竞争,将不再是单一模型智商的比拼,而是 Agent 集群协作效率的较量。