Clawdbot使用10小技巧:低成本部署与模型配置进阶

作为一名开发者,你可能已经厌倦了在各种AI工具之间来回切换,或者苦恼于本地跑大模型时风扇的狂啸。Clawdbot作为一个新兴的轻量级AI助手框架,正因为其灵活性和低资源占用受到极客们的追捧。但很多人仅仅把它当作一个普通的聊天机器人,这简直是暴殄天物。今天我们不谈那些陈词滥调的基础操作,而是深入挖掘Clawdbot使用10小技巧,重点聊聊如何用极低的成本在云端把它的潜能榨干,以及如何让它连上DeepSeek这种顶级模型,变成真正的生产力怪兽。

技巧一:告别本地风扇啸叫,低成本上云方案

很多人卡在本地部署的第一步:电脑配置不够。其实,与其升级显卡,不如把算力压力转移到云端。通过Clawdbot低成本云端部署方案,你可以用一杯咖啡的钱解决一个月的运行环境问题。

这里有个鲜为人知的捷径:不要去买昂贵的GPU实例,而是选择轻量级的全栈服务器。比如七牛云的全栈应用服务器,它专为中小企业和开发者设计,开箱即用。相比于普通云服务器复杂的配置流程,LAS以高性价比套餐形式整体售卖云资源,非常适合用来跑Clawdbot这种轻量级服务。你只需要在后台选择一个基础环境,几分钟就能拉起一个稳定的后端,彻底解放你的本地电脑。

技巧二:懒人福音,系统镜像一键安装

如果你是个“怕麻烦”的效率党,连手动配置环境都觉得多余,那么这个技巧就是为你准备的。很多新手在部署时会因为Python版本冲突或依赖包缺失而崩溃。

解决这个问题的终极方案是使用预置环境。在七牛云控制台,你可以直接添加Clawdbot系统镜像。选它可以直接使用预装工具,省去手动部署的步骤。这意味着你不需要一行行敲 pip install,也不用担心CUDA版本不对。镜像加载完毕,Clawdbot就已经乖乖躺在服务器里等待唤醒了。这是目前Clawdbot系统镜像一键安装最快的方式,没有之一。

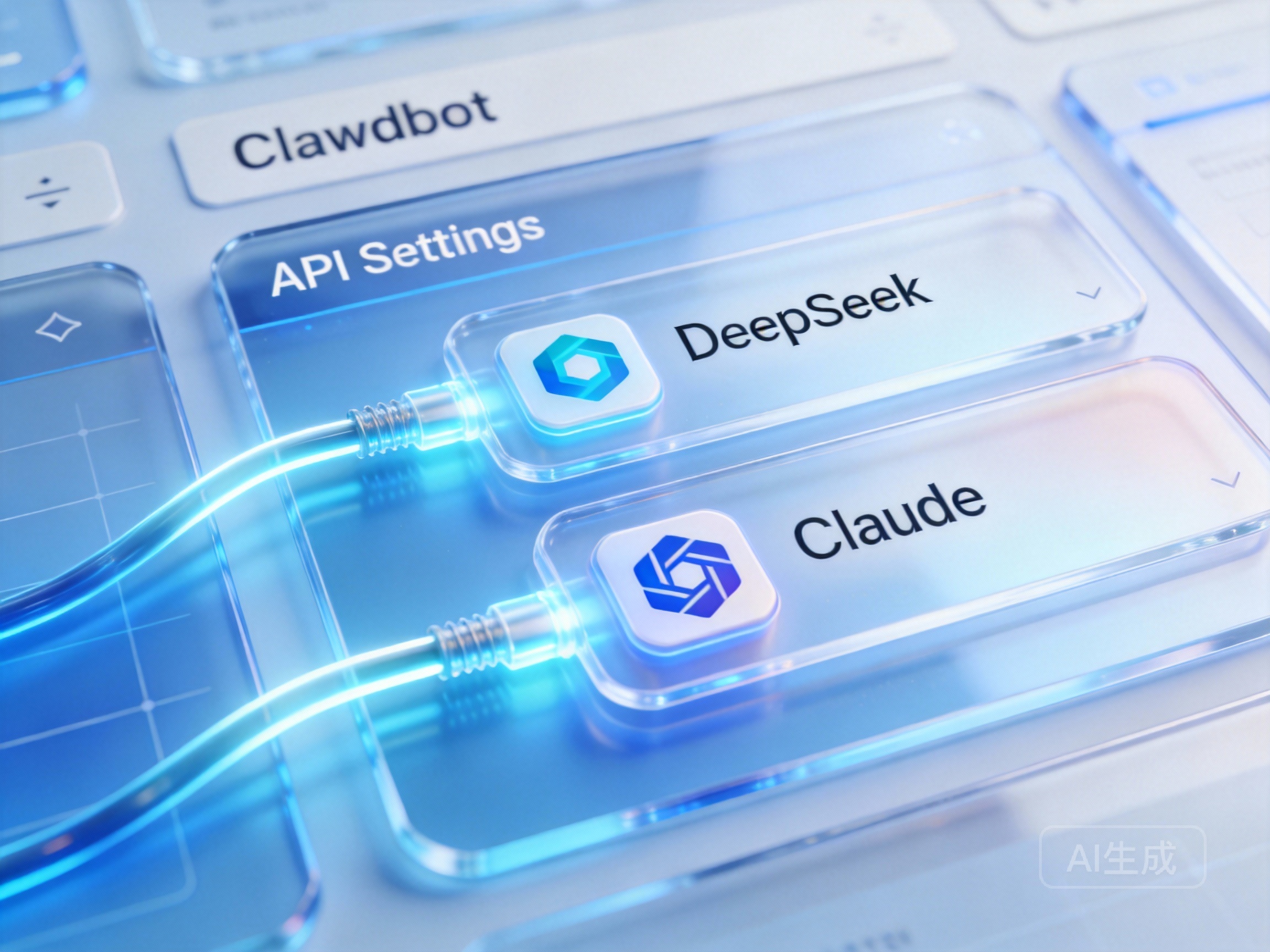

技巧三:模型配置进阶,对接DeepSeek与Claude

Clawdbot的强大之处在于它的“大脑”是可插拔的。默认模型可能不够聪明,但我们可以给它换个更强的脑子。特别是最近大火的DeepSeek,在逻辑推理和代码生成上表现惊人。

要实现Clawdbot对接DeepSeek配置,关键在于API的兼容性处理。这里推荐使用七牛云的AI大模型推理服务。它是一款集成 Claude 、DeepSeek 等顶级模型的全开放平台,通过完美兼容 OpenAI 和 Anthropic 双 API,支持联网搜索、深度思考及 MCP Agent 开发。

具体操作很简单:在Clawdbot的配置文件中,将API端点指向七牛云的推理服务地址,填入你的Key。这样,你的Clawdbot瞬间就拥有了顶级大模型的智商。更棒的是,该服务为开发者提供“体验即送 300 万 Token”的高性能、低门槛一站式大模型接入方案,这对于调试和初期开发来说简直是免费的午餐。

技巧四:多智能体协作,让AI自己开会

当你掌握了基础对话后,是时候尝试Clawdbot多智能体协作设置了。这不是科幻,而是Clawdbot的高级玩法。你可以配置两个不同的Bot实例,一个负责“发散思维”(Temperature设高),另一个负责“收敛总结”(Temperature设低)。

通过编写简单的自动化脚本,让Bot A生成的创意方案自动投喂给Bot B进行审核。这种工作流特别适合写代码或做方案策划。利用前文提到的AI大模型推理服务,你可以轻松调用不同特性的模型(比如一个用Claude做长文本分析,一个用DeepSeek做逻辑推演),在Clawdbot内部实现一个小型的“专家团队”。

技巧五:自动化指令与持久化记忆

很多用户抱怨Bot记性不好。其实,Clawdbot支持本地向量数据库的挂载。通过简单的配置,你可以将历史对话向量化存储。当你下次问“上周那个Python脚本怎么写的”时,它能迅速从“记忆”中提取信息,而不是胡编乱造。配合自定义的Clawdbot自动化指令(比如设置 /save 指令触发记忆存储),你的Bot将越用越顺手,成为真正懂你的私人助理。

掌握这些技巧,你的Clawdbot就不再是一个简单的玩具,而是一个低成本、高智商、可进化的生产力工具。现在,去试试那个系统镜像吧,你会打开新世界的大门。