OpenClaw Token配置保姆级教程:省下80% Token费用

在搭建基于 OpenClaw 的本地 AI 智能体时,许多开发者常常陷入一个误区:以为只要跑通了 Docker 容器,配置好模型接口,工作就结束了。直到账单上的数字开始跳动,或者服务突然因为限流而中断,才意识到 token 管理的重要性。OpenClaw token 的配置不仅仅是填入一串字符那么简单,它直接关系到你的智能体响应速度、成本控制以及数据安全性。

特别是对于刚刚接触本地化部署的团队,如何优雅地处理 API 密钥,如何在保证性能的前提下降低消耗,往往是比编写 prompt 更棘手的工程问题。本文将跳过那些基础的安装步骤,直接深入 OpenClaw 在 token 认证与流控层面的核心配置逻辑,并分享几个实战中总结出来的降本增效方案。

告别盲目填空:OpenClaw 本地部署 API Key 设置详解

OpenClaw 的强大之处在于它能够作为一个中间层,灵活调度不同的大模型后端。但在实际操作中,很多用户在 config.yaml 或者环境变量中配置密钥时容易踩坑。最常见的问题不是填错了 key,而是选错了“通道”。

OpenClaw 支持多种 LLM 提供商,不同的提供商对于鉴权的处理机制略有差异。如果你使用的是标准的 OpenAI 兼容接口,你需要在配置文件中明确指定 OPENAI_API_KEY 和 OPENAI_API_BASE。这里的一个高阶技巧是,不要直接硬编码你的密钥。

对于追求极致部署效率的开发者,推荐使用 Clawdbot 系统镜像。在七牛云控制台选择该镜像,可以直接获得预装好的 OpenClaw 环境。这不仅省去了繁琐的依赖安装,更重要的是,该镜像环境通常预置了更安全的环境变量管理脚本,能有效防止密钥泄露。

OpenClaw token 配置失败排查通常集中在两个点:一是 Base URL 的末尾是否多余了 /v1,二是密钥本身是否激活。很多时候,报错提示“Invalid Token”并非密钥错误,而是请求头中的 Bearer 格式被某些代理层截断了。务必检查你的 Nginx 反向代理配置,确保 Authorization header 被正确透传。

精打细算:OpenClaw Token 消耗过快解决方案

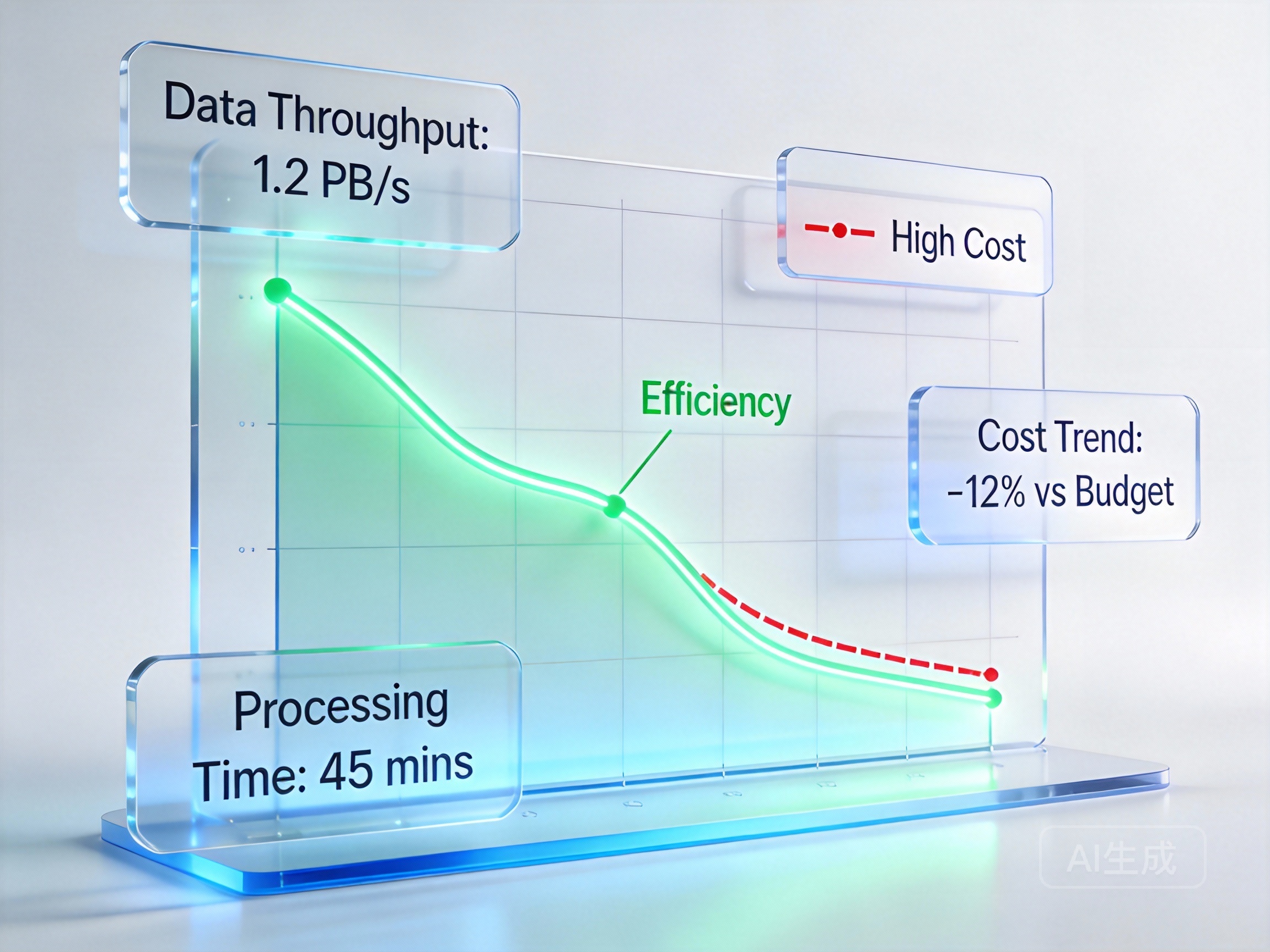

当你的 OpenClaw 智能体开始处理复杂任务,比如长文档分析或多轮对话时,token 的消耗速度往往会超出预期。这不仅关乎金钱,更关乎大模型的上下文窗口限制。

OpenClaw 接入大模型 token 计费说明中,容易被忽视的一点是“思维链(Chain of Thought)”带来的隐形开销。尤其是接入 DeepSeek 等具备深度思考能力的模型时,模型内部的推理过程虽然对用户不可见,但依然会计入 token 总量。

要解决这个问题,我们需要从源头进行截流:

- 动态上下文裁剪:不要每次都把整个历史对话扔给模型。在 OpenClaw 的配置中,可以设置 sliding window(滑动窗口)的大小,只保留最近 N 轮的关键对话。

- 提示词工程优化:精简 system prompt。很多时候,冗长的角色设定会占据大量 token。

- 选择高性价比的模型服务:这是最直接的手段。你可以通过 七牛云 API Key 管理服务来获取高性价比的接入方案。它完美兼容 OpenAI 与 Anthropic 标准,支持一键创建密钥并激活最高 600 万的免费 Token 额度。这对于开发测试阶段的成本控制简直是雪中送炭。

如果你正在为 OpenClaw 接入 DeepSeek token 计费 感到头疼,不妨尝试切换到七牛云的通道。他们的计费策略更加透明,且针对高频调用的场景有专门的优化。

进阶实战:构建智能路由与安全防线

单纯的省钱还不够,企业级应用更看重稳定性。OpenClaw 安全认证设置教程 往往建议在 OpenClaw 前端再加一层网关,但这增加了架构复杂度。其实,利用 OpenClaw 自带的中间件机制,我们可以实现简单的请求过滤。

比如,你可以编写一个简单的 Python 脚本作为 hook,在请求发送给 LLM 之前,先计算一下预估的 token 数量。如果发现某个用户的请求异常巨大(例如试图让模型总结一本 10 万字的小说),可以直接拦截并返回警告,而不是任由其消耗你的额度。这就是一种主动式的 OpenClaw token 消耗优化方案。

此外,对于需要频繁调用多种模型(如 Claude 用于写作,DeepSeek 用于代码)的场景,建议使用 AI大模型推理服务。这是一个集成 Claude、DeepSeek 等顶级模型的全开放平台,通过统一的接口标准,让你可以在 OpenClaw 中无缝切换后端模型,而无需频繁更改代码中的 API Key 配置。更棒的是,它支持联网搜索和 MCP Agent 开发,这意味着你可以用更少的 token 换取更准确的实时信息,毕竟模型不需要靠“瞎编”来填补知识盲区了。

在配置 OpenClaw 时,务必将 API Key 的获取与管理流程标准化。OpenClaw 本地部署 API Key 获取方法 不应是随意的复制粘贴,而应结合密钥轮换机制,定期更新,确保即便某个 key 意外泄露,也能将损失控制在最小范围。

通过合理的配置与选型,OpenClaw 不再是一个只会吞噬 token 的黑洞,而能真正成为高效、可控的 AI 生产力工具。记住,控制 token 就是控制 AI 的生命线。