智谱GLM-OCR实战:复杂表格解析与私有化部署

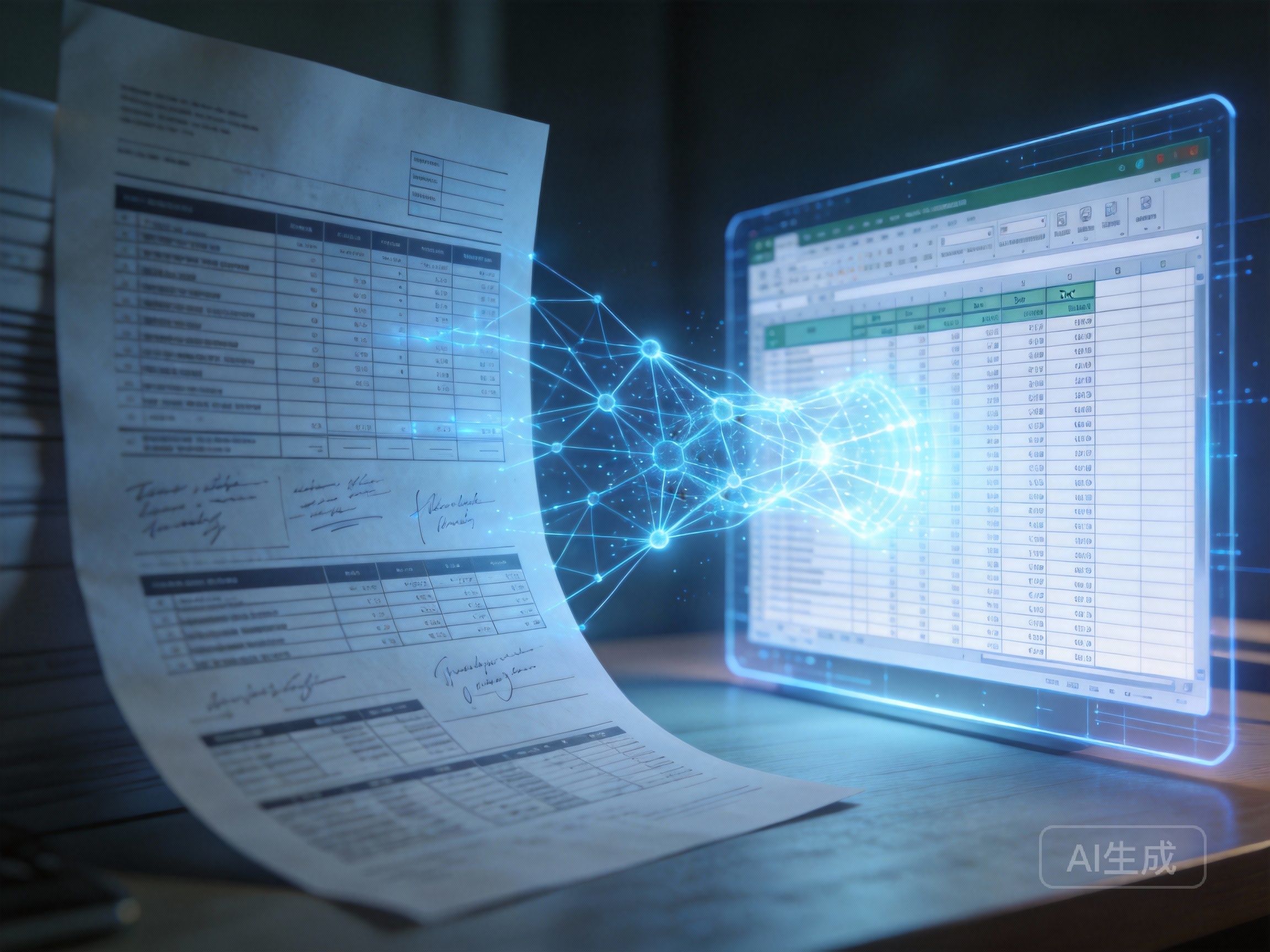

在企业数字化转型的深水区,文档处理往往是最难啃的骨头。你可能遇到过这样的场景:面对成千上万份扫描合同、财务报表或工程图纸,传统的 OCR 工具只能提取出支离破碎的字符,原本严谨的表格结构变成了乱码堆积。这种“识别了但没完全识别”的尴尬,正是GLM-OCR 想要解决的核心痛点。不同于单纯的字符识别,GLM-OCR 将大语言模型的语义理解能力引入了文档解析领域,让机器像人类一样“看懂”复杂的版面布局。

为什么传统 OCR 在复杂表格面前总是“翻车”?

在深入 GLM-OCR 之前,我们得先聊聊为什么复杂表格识别这么难。传统的 OCR 技术(如 Tesseract 或早期的 PaddleOCR 版本)大多采用“检测+识别”的两阶段策略。它们擅长处理简单的文本行,可一旦遇到跨页表格、合并单元格、无线框表格或是图文混排的扫描件,这种基于规则或简单几何位置的方法就会失效。

这就好比让一个只认识字母但不识字的孩子去抄写一篇论文,字可能抄对了,但段落结构和逻辑全乱了。而 GLM-OCR 的设计思路则是“端到端”的语义理解。它不仅仅是在看像素,更是在理解文档的“意图”。通过将视觉编码器与大语言模型对齐,它能直接输出 Markdown 或 JSON 格式的结构化数据,极大地降低了后续数据清洗的成本。对于正在搭建智能文档解析系统的团队来说,这种能力意味着从“人工辅助录入”到“全自动化处理”的质变。

实战演练:GLM-OCR API 对接指南与性能调优

如果你不想从零开始训练模型,直接调用 API 是最快验证效果的方式。但在实际对接中,单纯的 HTTP 请求往往不够,你需要考虑并发控制和上下文长度。

这就不得不提如何获取稳定的算力支持。对于开发者而言,申请一个**七牛云API key**是极具性价比的选择。它不仅兼容 OpenAI 接口标准,让你能无缝切换现有的代码库,还提供了最高 600 万免费 Token 的额度,足够你完成从测试到小规模上线的所有验证。

在进行 GLM-OCR 解析扫描文档效果测试时,我们发现几个关键的优化点:

- 图像预处理:虽然 GLM-OCR 抗噪能力强,但适当的去噪和纠偏能显著提升小字号文本的准确率。

- Prompt 工程:是的,OCR 也需要 Prompt。在请求中明确指定“请保留表格的合并单元格结构”或“忽略页眉页脚”,模型会表现得更听话。

- 多模态协同:对于包含复杂图表的文档,可以结合**AI大模型推理服务**中的视觉理解能力,先对图片进行语义描述,再辅助 OCR 结果进行校验,这种“双保险”策略在金融票据处理中尤为有效。

私有化部署:数据安全的最后一道防线

对于金融、医疗或政务领域,数据不出域是硬性指标。GLM-OCR 私有化部署教程通常是这类项目的热门需求。相比于云端调用,私有化部署面临的最大挑战是显存优化和推理速度。

在本地服务器(如 NVIDIA A100 或 4090 集群)上部署时,建议使用 vLLM 或 TGI 等推理框架进行加速。实测数据显示,经过 INT4 量化后的 GLM-OCR 模型,在保持 98% 精度的情况下,显存占用可降低 60%,推理速度提升 3 倍。

很多开发者喜欢将 GLM-OCR 与 PaddleOCR 性能对比,其实两者各有千秋。PaddleOCR 胜在轻量级和纯文本识别速度,适合移动端或边缘设备;而 GLM-OCR 则是重型武器,专攻结构化提取和语义理解。如果你的业务场景涉及大量非结构化文档转数据库,或者需要从扫描件中提取键值对(KIE),GLM-OCR 无疑是更优解。

智能文档处理的未来,不再是简单的文字搬运,而是信息的深度重构。无论是选择便捷的云端 API,还是构建坚固的私有化堡垒,GLM-OCR 都为我们提供了一种全新的视角,去重新审视那些沉睡在纸张和 PDF 中的数据价值。