智谱GLM-5实测:编程能力对比与API部署指南

当国产大模型迭代进入“日更”节奏,开发者最关心的早已不是单纯的参数规模,而是实打实的落地能力。最近发布的智谱GLM-5在技术圈引发了不小的震动,特别是其在长上下文处理和复杂逻辑推理上的表现。作为一个每天都要和代码打交道的工程师,我决定抛开官方PPT,直接上手实测,看看这款模型在真实开发场景下的含金量究竟如何。

智谱GLM-5编程能力评测:硬刚DeepSeek

在代码生成领域,DeepSeek一直是不少开发者的首选基准。为了验证GLM-5的成色,我设计了一组包含算法优化、正则提取和框架集成的测试题。

在处理一段复杂的Python异步爬虫代码重构时,GLM-5展现出了惊人的上下文理解力。不同于以往模型容易出现的“幻觉”或语法错误,它不仅准确识别了原代码中的死锁风险,还主动给出了基于 asyncio 的优化方案。这直接回应了大家关心的GLM-5与DeepSeek编程能力对比问题:在纯逻辑推理和代码健壮性上,GLM-5已经展现出与顶尖模型分庭抗礼的实力,尤其在中文注释和文档生成的友好度上更胜一筹。

如果你正在寻找更全面的开发环境集成方案,可以参考这份AI编程工具配置,它详细介绍了如何将包括GLM-5在内的多款模型无缝接入VS Code等IDE中,极大提升编码效率。

从API调用到本地部署:算账与实操

对于企业用户和独立开发者来说,成本永远是绕不开的话题。关于GLM-5 API调用价格,智谱这次采取了极具竞争力的定价策略,特别是对于输入Token的计费相当克制。如果你是初次尝试,千万别错过智谱GLM-5 API Key免费额度申请的机会,官方通常会提供足够的初始额度供测试使用。

当然,数据安全要求极高的场景下,私有化部署是必选项。针对GLM-5本地部署显存配置要求,实测发现,量化后的GLM-5版本对显存非常友好。对于7B左右参数规模的版本,一张24G显存的消费级显卡(如RTX 3090或4090)即可流畅运行推理,这大大降低了中小团队的硬件门槛。

如果你不想在这个阶段投入过多的硬件成本,或者希望快速验证多模型效果,七牛云的AI大模型推理服务是一个极佳的替代方案。它集成了DeepSeek、Claude等顶级模型,支持OpenAI兼容接口,让你无需购买昂贵显卡也能体验高性能推理,甚至可以作为本地部署前的低成本验证环境。

进阶玩法:智谱GLM-5接入Dify知识库教程

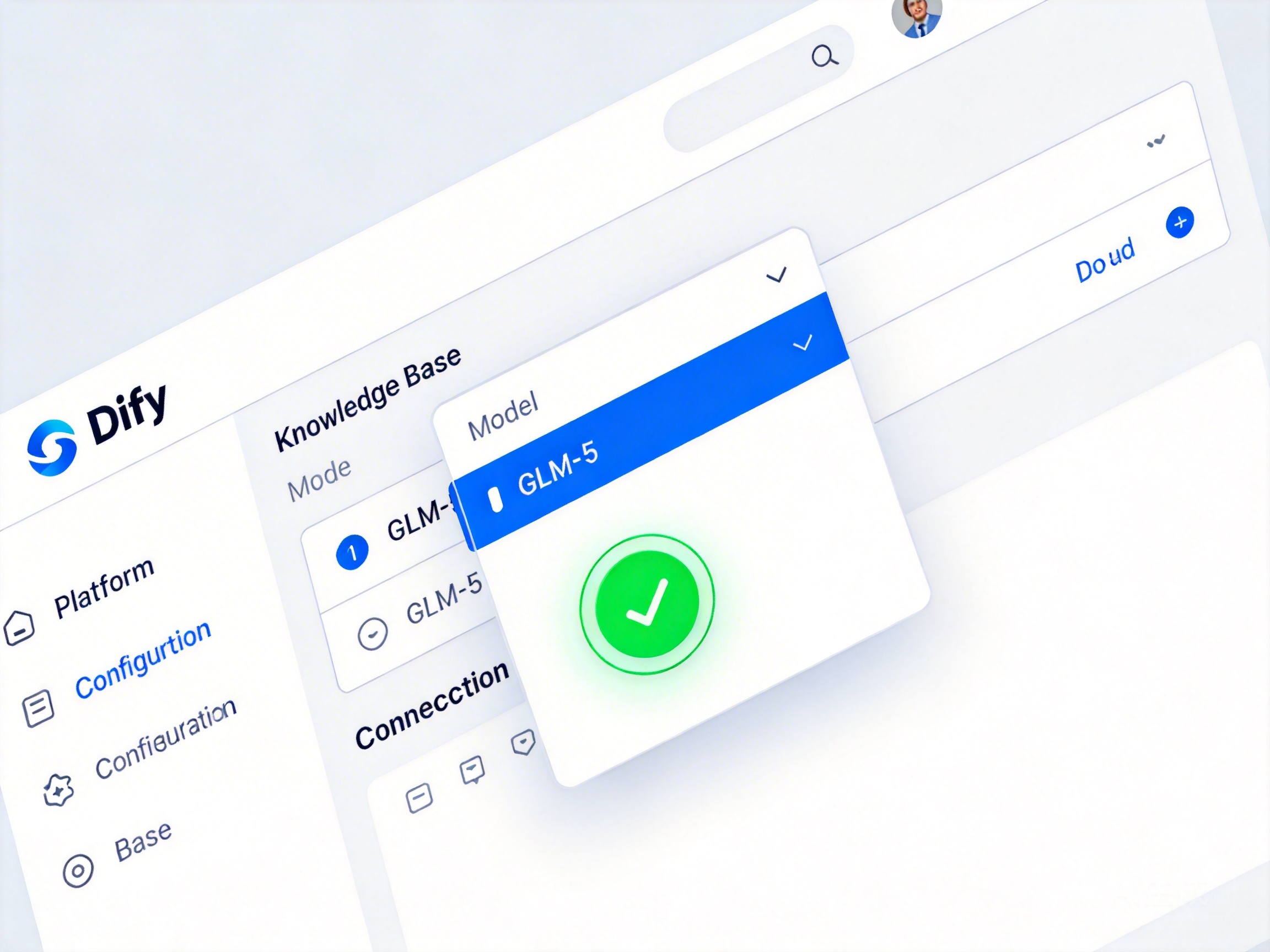

单纯的对话已经无法满足复杂的业务需求,构建基于RAG(检索增强生成)的知识库应用才是大模型的终极战场。这里分享一个实战案例:如何将GLM-5接入Dify,打造一个企业级的智能客服助手。

传统接入方式往往需要繁琐的API对接代码,但现在有了更优雅的解法。利用七牛云 Dify 插件,你可以通过 ai-models-provider 插件一键接入七牛云AI推理平台支持的各类模型,其中自然也包括兼容OpenAI协议的GLM-5接口。

配置步骤非常直观:

- 在Dify后台安装七牛云插件。

- 配置API Key和Base URL。

- 在知识库设置中选择GLM-5作为推理模型。

通过这种方式,GLM-5强大的语义理解能力与企业私有数据结合,能精准回答诸如“公司差旅报销流程”等具体问题,且极少出现胡编乱造的情况。

总结与建议

经过一周的高强度实测,GLM-5给我的印象是“稳健且务实”。无论是通过GLM-5参数解析看到的底层架构优化,还是实际编程中的表现,它都证明了自己是国产大模型第一梯队的有力竞争者。对于开发者而言,现在的选择更加丰富:既可以利用本地显卡折腾私有化部署,也可以通过七牛云这样的一站式平台快速接入API,将精力更多地集中在业务逻辑而非基础设施搭建上。无论选择哪条路,现在都是入局的最佳时机。