提示词越长越笨?破解AI大模型上下文稀释难题

很多开发者在与大模型“磨合”时,常陷入一个误区:既然模型支持 128k 甚至更长的上下文,那我把所有相关资料一股脑塞进去,效果一定最好。然而现实往往很骨感,你精心准备的万字长文Prompt,换来的却是一个答非所问、逻辑混乱的回复。这种现象,被业内戏称为“提示词越长越笨”。

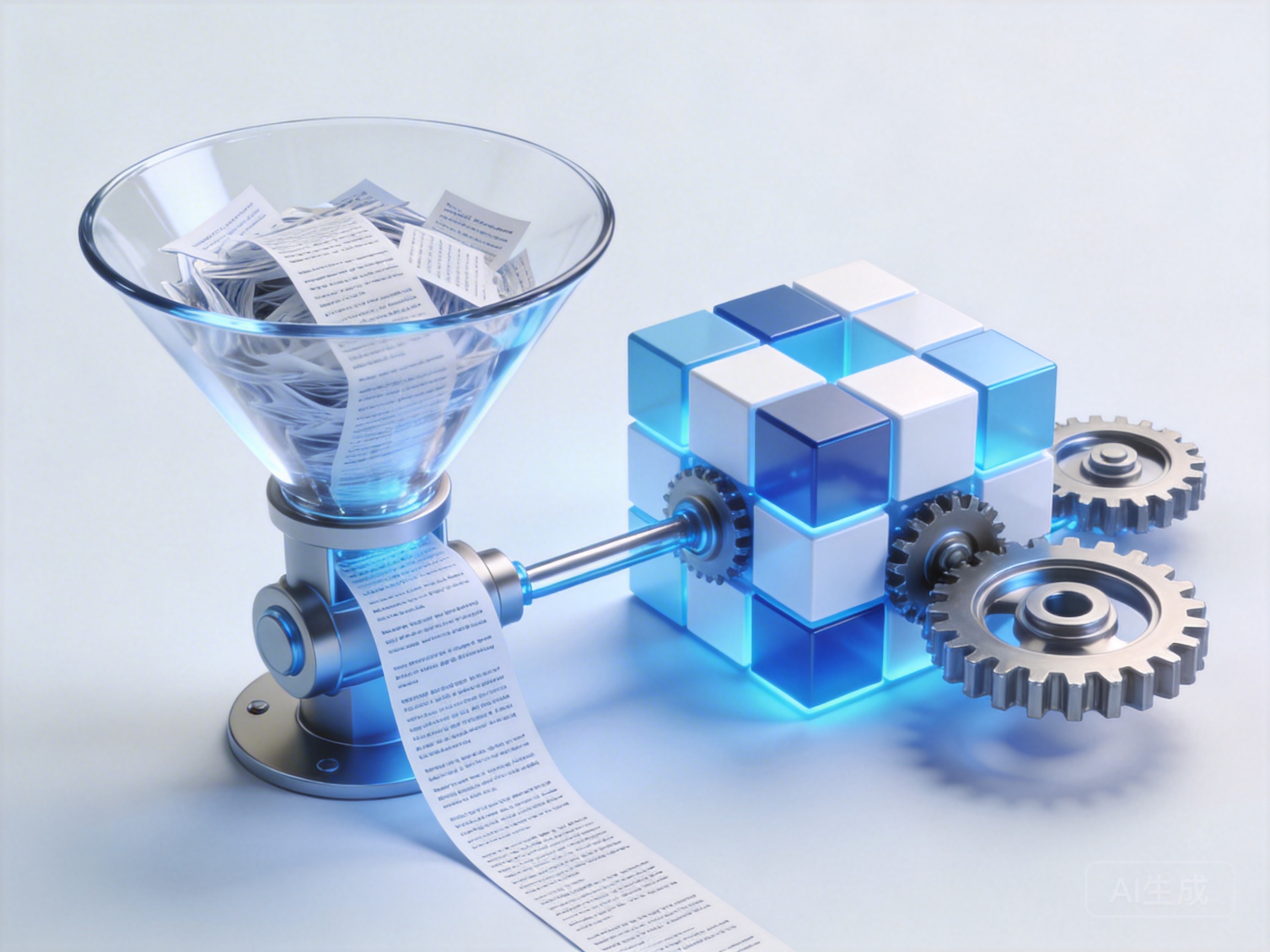

这并非模型“智商”下降,而是遭遇了典型的“上下文稀释”(Context Dilution)效应。就像在嘈杂的集市中试图听清一个人的耳语,当无关信息噪音过大,模型捕捉核心指令的能力就会显著衰减。

为什么你的Prompt正在“稀释”模型的智商?

要解决这个问题,首先得理解大模型是如何“阅读”你的提示词的。现在的Transformer架构虽然具备强大的长文本处理能力,但在注意力机制(Attention Mechanism)分配上并非绝对平均。研究表明,模型对Prompt开头和结尾的信息关注度最高,而中间部分常常成为“注意力洼地”,这就是著名的“迷失在中间”(Lost in the Middle)现象。

当你为了追求所谓的“全面”,在Prompt中堆砌大量非必要的背景描述、冗余的示例或者相互冲突的约束条件时,实际上是在主动制造噪音。这些噪音不仅消耗了宝贵的Token额度,更导致AI模型长文本注意力分散解决方案失效,让模型在推理时找不到重点。

这就好比给一个厨师下达指令,如果你只是说“做一份宫保鸡丁”,他能做得很好;但如果你在指令中夹杂了“昨天天气不错”、“隔壁老王喜欢吃辣”、“记得洗手”、“不要用坏掉的锅”等几千字无关紧要的碎碎念,厨师最后可能连鸡丁都忘了切。

告别“小作文”:高信噪比的 Prompt Engineering 实战

破解这一难题的核心,在于提升 Prompt 的“信噪比”。我们需要从单纯的“堆料”转向精准的“引导”。

1. 结构化降噪与模块化拆解

与其写一篇长篇大论,不如将 Prompt 结构化。使用清晰的分隔符(如 ### 或 ---)将指令、背景、示例和输出要求严格分开。更进阶的做法是采用模块化思维。

如果你的任务非常复杂,涉及多步骤推理,建议不要试图在一个 Prompt 中解决所有问题。利用 AI大模型推理服务 提供的多轮对话能力,将一个复杂任务拆解为多个子任务链。七牛云集成了 Claude 3.5 Sonnet、DeepSeek 等擅长逻辑推理的顶级模型,通过 API 逐步引导模型完成任务,能有效避免单次输入过长导致的幻觉。

2. 动态上下文管理:只给最需要的

如何避免提示词过长导致的幻觉?关键在于动态管理上下文。不要把整个知识库都塞进去,而是利用 RAG(检索增强生成)技术,只检索与当前问题最相关的片段。

对于需要调用外部工具或复杂逻辑的场景,可以参考 MCP服务使用说明文档。通过七牛云 MCP(Model Context Protocol)服务,你可以构建一个能够自主调用工具的 Agent。这意味着你不需要在 Prompt 中详细描述每一个工具的用法,而是让模型通过标准化的协议按需调用,大大减少了 Prompt 的长度,同时提升了执行的准确性。

3. 利用模型特性“反向压缩”

不同的模型对长文本的耐受度不同。在 AI大模型广场 中,你可以找到针对长上下文优化的特定模型版本。有些模型擅长处理百万级 Token,而有些则在短小精悍的指令下表现更佳。

七牛云大模型长上下文处理技巧之一,就是学会利用模型进行“自我压缩”。在进行正式任务前,可以先让模型总结冗长的背景材料,生成一个高密度的摘要,再基于这个摘要进行后续的问答。这种“模型读给模型听”的方法,往往比人类直接缩写效果更好,且保留了模型认为关键的语义信息。

结语

“提示词越长越笨”不仅是一个技术调优问题,更是一种思维方式的转变。从“填鸭式”投喂到“引导式”交互,才是释放大模型潜力的正解。当你学会做减法,剔除噪音,保留信号,你会发现,哪怕只有寥寥数语,AI 也能展现出惊人的洞察力。下次当你觉得模型变“笨”时,不妨先检查一下,是不是你的 Prompt 给得太“满”了。